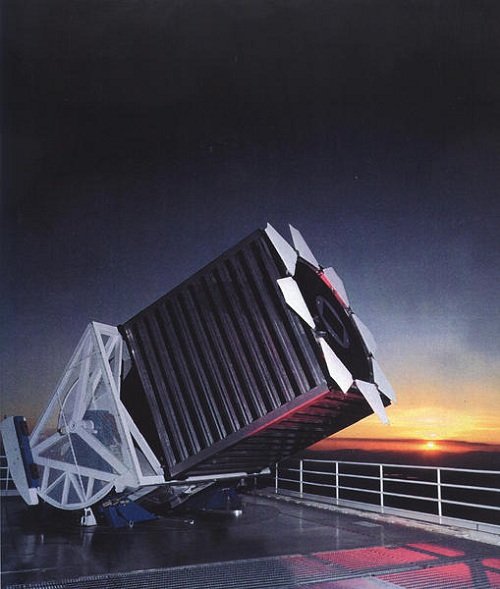

Utilizando el Telescopio Muy Grande (VLT) de ESO en el norte Chile, astrónomos europeos han demostrado por primera vez que un magnetar – un inusual tipo de estrella de neutrones – se formó a partir de una estrella de al menos 40 veces la masa del Sol. El resultado desafía las actuales teorías sobre evolución estelar pues se esperaba que una estrella tan masiva como ésta se convirtiera en un agujero negro, no en un magnetar. Esto genera una pregunta fundamental: ¿cómo de masiva tiene que ser realmente una estrella para convertirse en un agujero negro?

Utilizando el Telescopio Muy Grande (VLT) de ESO en el norte Chile, astrónomos europeos han demostrado por primera vez que un magnetar – un inusual tipo de estrella de neutrones – se formó a partir de una estrella de al menos 40 veces la masa del Sol. El resultado desafía las actuales teorías sobre evolución estelar pues se esperaba que una estrella tan masiva como ésta se convirtiera en un agujero negro, no en un magnetar. Esto genera una pregunta fundamental: ¿cómo de masiva tiene que ser realmente una estrella para convertirse en un agujero negro?

Para llegar a estas conclusiones, los astrónomos miraron en detalle el extraordinario cúmulo estelar Westerlund 1, ubicado a 16 000 años-luz de distancia, en la austral constelación de Ara (el Altar). A partir de estudios anteriores, los astrónomos sabían que Westerlund 1 es el súpercúmulo de estrellas más cercano conocido, con cientos de estrellas muy masivas en su interior – algunas que brillan con un resplandor similar a casi un millón de soles – y una extensión de unas doscientas veces el diámetro del Sol (similar a la órbita de Saturno).

“Si el Sol estuviese ubicado en el corazón de este notable cúmulo, nuestro cielo nocturno estaría lleno de cientos de estrellas tan brillantes como la Luna llena”, dice Ben Ritchie, autor principal del artículo que presenta estos resultados.

Westerlund 1 es un fantástico zoológico estelar, con una población de estrellas diversa y exótica. Las estrellas del cúmulo tienen algo en común: todas alcanzan la misma edad, estimada en entre 3,5 y 5 millones de años, debido a que el cúmulo se creó en un solo evento de formación estelar.

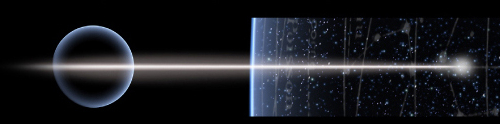

Un magnetar es un tipo de estrella de neutrones con un campo magnético tremendamente fuerte – 1015 veces más fuerte que el de la Tierra-, que se forma cuando ciertas estrellas explotan como supernovas. El cúmulo Westerlund 1 alberga uno de los pocos magnetares conocidos en la Vía Láctea. Gracias a que se encuentra en el cúmulo, los astrónomos pudieron llegar a la notable deducción de que este magnetar debe haberse formado a partir de una estrella al menos 40 veces más masiva que el Sol.

Como todas las estrellas en Westerlund 1 tienen la misma edad, la estrella que explotó y dejó un remanente de magnetar debió tener una vida más corta que las estrellas sobrevivientes en el cúmulo. “Como el tiempo de vida de una estrella está directamente relacionado a su masa –mientras más masiva sea una estrella, más corta será su vida-, si podemos medir la masa de cualquier estrella sobreviviente sabremos con seguridad que la estrella de vida más corta que se convirtió en el magnetar debió ser incluso más masiva”, dice el coautor y líder del equipo Simon Clark. “Esto tiene gran importancia pues no existe una teoría aceptada sobre cómo se formaron estos objetos extremadamente magnéticos”.

Los astrónomos, por tanto, estudiaron las estrellas que pertenecen al sistema doble eclipsado W13 en Westerlund 1, utilizando el hecho de que en un sistema como éste las masas pueden ser calculadas directamente a partir del movimiento de las estrellas.

Al comparar con estas estrellas, descubrieron que la estrella que se convirtió en un magnetar debió tener al menos 40 veces la masa del Sol. Esto prueba por primera vez que los magnetares pueden desarrollarse a partir de estrellas que, por su gran masa, se esperaría que formen agujeros negros. Hasta ahora se suponía que las estrellas con masas iniciales de entre 10 y 25 masas solares se convertían en estrellas de neutrones, mientras que aquéllas sobre 25 masas solares producían agujeros negros.

“Estas estrellas deben deshacerse de más de 9 décimos de su masa antes de explotar como supernova, o de otra forma crearían un agujero negro”, dice el coautor Ignacio Negueruela. “Pérdidas de masa tan enormes antes de la explosión presentan grandes desafíos a las actuales teorías de evolución estelar”.

“Esto genera la inquietante pregunta de cuán masiva tiene que ser una estrella para colapsar y formar un agujero negro, si estrellas que son más de 40 veces más masivas que nuestro Sol no pueden conseguir esta proeza”, concluye el coautor Norbert Langer.

El mecanismo de formación preferido por los autores de este estudio postula que la estrella que se convirtió en magnetar – la progenitora – nació con una compañera estelar. A medida que ambas estrellas se fueron desarrollando, comenzaron a interactuar, consumiendo la energía derivada del movimiento orbital en eyectar grandes cantidades de masa desde la estrella progenitora. Si bien la compañera no es actualmente visible en la zona del magnetar, ello puede deberse a que la supernova que formó el magnetar provocó el quiebre del sistema binario, eyectando a ambas estrellas a alta velocidad desde el cúmulo.

“Si este es el caso, los sistemas binarios jugarían un rol clave en la evolución estelar, provocando pérdidas de masa – una “dieta” cósmica perfecta para estrellas de gran peso, que permite perder hasta un 95% de la masa inicial”, concluye Clark.

Artículo de Referencia

Fecha Original: 18 de agosto de 2010

Enlace Original